Статья подготовлена на основе выступления на SEO Conference 2017

Основатель агентства «Муравейник»

Большинство клиентов не готовы ждать отдачи от продвижения много месяцев. Поэтому быстрое получение первых результатов – одна из приоритетных задач как для SEO-агентств, так и для штатных специалистов.

Мы решаем эту задачу, делая акцент в первые месяцы работы на запросах с достаточной популярностью и высокой вероятностью выхода в ТОП.

Проверим гипотезы

Для эксперимента взяли чуть больше 100 тысяч «грязных» запросов, используя базы поисковых слов, SpyWords, Serpstat, подсказки, статистику Директа и AdWords и другие. Спарсили запросы, соединили в одну таблицу и поставили задачу их оценить.

Существует такое понятие, как Keyword Effectiveness Index (KEI). Это коэффициент эффективности запроса.

Что в нем обычно учитывается:

- Количество документов в ПС Яндекс, а именно количество фактических документов конкурентов.

- Количество главных страниц в ПС Яндекс.

- Вхождения в главные заголовки.

- Ссылки.

- тИЦы.

- Возраст и так далее.

Для проверки этих и других факторов мы написали скрипт, в который на вход подается:

- список запросов,

- регион,

- списки похожих и непохожих сайтов-конкурентов.

Также сделали возможность подать произвольные параметры доменов конкурентов: к примеру, возраст, количество документов в индексе.

На выходе получаем:

- Рейтинг похожести ТОПа. Он показывает, насколько много в ТОПе по каждому запросу сайтов, похожих на наш сайт и сколько отличающихся

- Медианное значение тех произвольных параметров по ТОПам, которые мы подгрузили на вход.

Чтобы проверить гипотезу, необходимо рассчитать корреляцию и понять, как работает тот или иной фактор. Мы тестировали разные варианты, в итоге одинаково хорошо себя показали две корреляции:

➢ С текущей позиции сайта. Мы берем случайный сайт, не зная историю позиций, и смотрим, по каким запросам он в ТОПе. И смотрим корреляцию выросших запросов с каждым фактором.

➢ С ростом позиций. Мы берем позицию сайта год назад или полгода назад, позицию в настоящий момент. И так же сравниваем с факторами.

Чтобы иметь возможность использовать больше данных, в эксперименте мы использовали корреляцию с текущей позицией.

Для оценки взяли факторы:

- Количество документов в ПС Яндекс [KEI]

- Sumantra Roy KeI

- Количество главных страниц в ПС Яндекс [KEI]

- Ссылающиеся домены по LinkPad

- Бэклинки по MI

- Количество вхождений в заголовки в ПС Яндекс [KEI]

- Возраст конкурентов

- тИЦ конкурентов

- тИЦ по похожим конкурентам

- Majestic CF

- Количество страниц в индексе Яндекса у конкурентов

- Траф с органики по MI (похожие)

- Рейтинг Alexa

- Похожесть

Расскажу о каждом подробнее.

Количество документов в ПС Яндекс — это довольно интересный параметр, потому что он появился в расчете KEI от Sumantra Roy больше 15 лет назад. На тот момент это было более или менее корректно, потому что в Google по многим запросам документов было не так много, и цифра была адекватная.

Яндекс же на данный момент эту цифру выдает в десятках миллионов, вследствие чего невозможно оценить, насколько реально конкурентный запрос по этому фактору. В результате эксперимента мы получаем обратную корреляцию: чем больше конкурирующих документов, тем лучше для нас, что в принципе ложная история, которую никак нельзя использовать для оценки запросов. Формулу Sumantra Roy очень многие используют по умолчанию. Но она неверно работает, поэтому ее необходимо менять.

Вывод: Не подходит

Sumantra Roy KEI — средняя корреляция составляет практически 0%, то есть никак не коррелирует с вероятностью выхода запроса.

Вывод: Не подходит

Количество главных страниц в ПС Яндекс.

Линия трендов на скриншоте коррелирует с точками. Точки — значения. По горизонтальной оси — это количество главных страниц в ТОПе, по вертикали — позиция. Мы видим, что чем больше главных страниц в ТОПе — тем позиция выше.

Так происходит потому, что этот фактор больше коррелирует с «коммерческостью» запроса. Чем более коммерческий запрос, тем выше вероятность выхода главных страниц. Соответственно, продвигая коммерческий сайт, нам гораздо проще продвинуться по коммерческому запросу. Корреляция довольно сильная — плюс 11%. Чем больше морд в ТОПе, тем лучше для нас. Но нам опять же это никак не помогает, и указанный фактор мы отбрасываем.

Вывод: Не подходит

Ссылающиеся домены по LinkPad.

Средняя корреляция +5%, то есть чем больше ссылок на конкурентов, тем хуже для нас. Все логично, но корреляция довольно низкая. Связано это и с тем, что у LinkPad сейчас слабая база, недостаточно актуальна в сравнении с другими.

Вывод: Лучше не использовать

Бэклинки по Megaindex. Ситуация аналогичная, но здесь мы собирали не ссылающиеся домены, а все ссылки.

Корреляция довольно слабая — минус 4%.

Чем больше ссылок для конкурентов, тем хуже для нас.

Вывод: Лучше не использовать

Вхождения в заголовки в ПС Яндекс. Средняя корреляция — минус 6%. Чем больше вхождений в заголовки страниц конкурентов, тем хуже для нас. Но это уже лучше, чем предыдущие параметры.

Возраст конкурентов. Средняя корреляция — минус 11%. Чем больше возраст конкурентов, тем хуже для нас. Многие используют этот параметр и правильно делают.

Вывод: Можно использовать

тИЦ конкурентов. На графике видим, что распределение по ТИЦ довольно равномерное, корреляция невысокая — минус 5%.

Чем больше ТИЦ конкурентов, тем хуже для нас.

Вывод: Лучше не использовать

тИЦ по похожим конкурентам. В процессе исследования мы оценивали сайты конкурентов, похожие и непохожие на нас. Через это получили возможность сравнивать и параметры не только по всей выборке, а только по похожим сайтам. В этом случае ТИЦ по похожим сайтам показал себя заметно лучше, чем общий ТИЦ.

Средняя корреляция составила минус 15%.

Чем больше ТИЦ у похожих сайтов конкурентов, тем хуже для нас.

Вывод: Можно использовать

Majestic CF. Мы взяли CF и TF. ТF показал себя не очень хорошо, СF — отлично!

Средняя корреляция: минус 14%.

Чем больше СF у сайтов конкурентов, тем хуже для нас.

Вывод: Можно использовать

Страницы в индексе Яндекса у конкурентов.

Средняя корреляция минус 14%.

Чем больше страниц в индексе конкурентов, тем хуже для нас.

Вывод: Можно использовать

Трафик с органики по Megaindex по похожим конкурентам.

По непохожим сайтам средняя корреляция – слабая, по похожим – заметная, минус 11%.

Чем больше трафик с органики в индексе конкурентов, тем хуже для нас.

Вывод: Можно использовать

Рейтинг Alexa. Мы рассмотрели некоторые трафиковые параметры, неплохо себя показал Alexa, хотя для России его релевантность нам не совсем понятна. Но в итоге параметр хорошо работает под оценку для Яндекса. Средняя корреляция — минус 12%. У всех сайтов отрицательная. Чем лучше рейтинг Alexa конкурентов и выше трафик, тем хуже для нас.

Вывод: Можно использовать

Далее мы перешли к тем параметрам, которые, практически никто не использует в своей оценке.

Похожие конкуренты в ТОПе

На скриншоте график зависимости числа похожих документов в ТОП 20 и позиции.

Соответственно, чем больше похожих на наш сайтов, тем выше наша позиция. Мы видим, что при большом количестве похожих сайтов практически нет запросов ниже 20 позиции, все в ТОПе. Средняя корреляция +25%.

Это больше, чем любой из остальных параметров.

Чем больше похожих сайтов в ТОПе, тем лучше для нас.

Вывод: Нужно использовать обязательно

Похожие конкуренты в ТОПе

Аналогично работает фактор по непохожим сайтам. Чем больше непохожих сайтов, тем выше наша позиция. Средняя корреляция минус 17%.

Чем больше непохожих сайтов в ТОПе, тем хуже для нас.

Вывод: Нужно использовать

Рейтинг похожести.

Обратим внимание на рейтинг похожести. На скриншоте видно скопление значений в нижней части графика там, где индекс похожести низкий и в верхней части – где он высокий.

Сумма параметров (кроме похожести).

Далее мы сложили все значимые параметры из этого исследования, кроме похожести. Опять же видим, что при низкой сумме всех параметров топовые позиции практически отсутствуют, преобладают низкие.

При высоком рейтинге количество запросов в ТОПе растет. Здесь не так ярко это видно по скоплению значений, но видно, если посмотреть на запросы в ТОП 10 и по линии тренда.

Средняя корреляция — плюс 26%.

Чем выше суммарный рейтинг по сумме параметров, тем лучше для нас.

Итоговый рейтинг

В нем мы собрали все параметры вместе с «рейтингом похожести».

При низком итоговом рейтинге наблюдаем скопления невысоких показателей, топовые позиции растут при высоком суммарном рейтинге. Средняя корреляция — 35%.

Проверим скорость работы с учетом похожести

Эта методика хорошо работает как на оценку небольшой группы запросов, так и на быструю фильтрацию списка на десятки и сотни тысяч запросов.

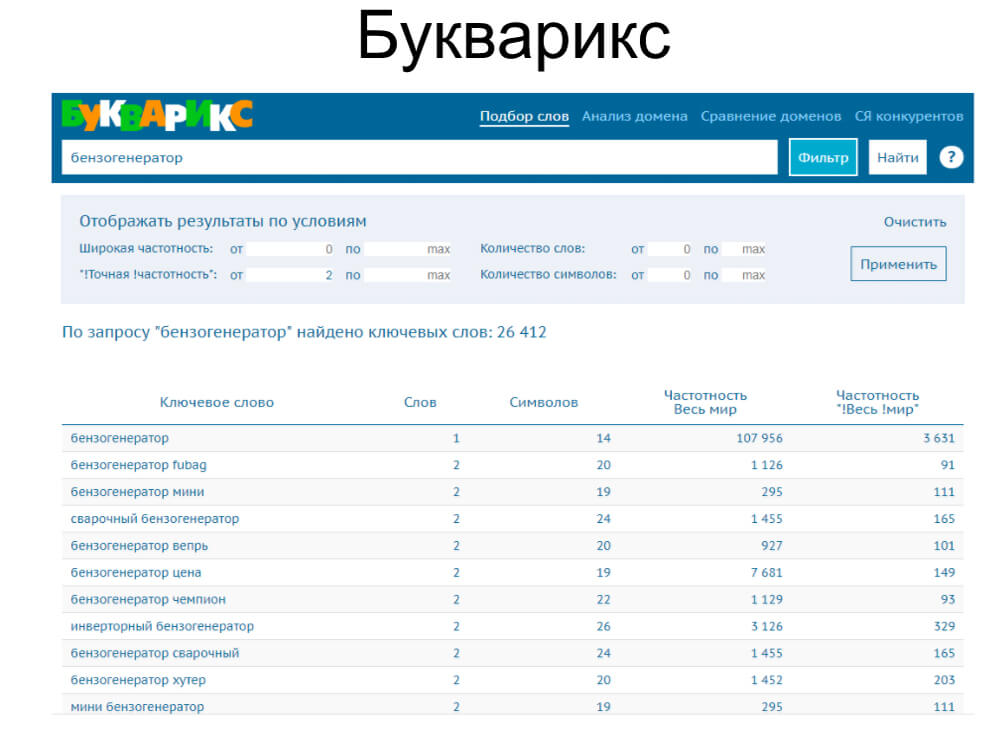

В тестировании использовали несколько сервисов: SerpStat, SpyWords, Букварикс и Муравейник tools.

Serpstat. По времени затратили 4 минуты, получили 4300 запросов основных конкурентов.

Букварикс. Собрали 75 000 запросов, затратили 7 минут. Запросы старались брать не нулевые, использовали фильтр от 2 и более точной частоты.

SpyWоrds. Затратили 4 минуты, собрали 20 000 запросов.

В KeyCollector отсеяли запросы с низкой частотой. Почти половина запросов отсеялась, осталось мене 55 000.

Затратили 2 минуты вручную, и 1 час работал сервис.

Муравейник Tools. На вход подали список запросов. Оценили несколько сайтов конкурентов как похожие/непохожие. Выгрузили итоговую таблицу.

Получили результат в виде списка данных. Сортируя таблицу по рейтингу, мы видим подходящие нам запросы, в ТОП 20 входит очень много похожих сайтов, непохожие отсутствуют. Далее мы исключаем запросы с низким рейтингом. Если находим запросы с высоким рейтингом, но не видим здесь позиции нашего сайта, мы ищем причины, почему так. В большинстве случаев оказывается, что на странице отсутствует эта ключевая фраза. Добавляем, и в большинстве случаев запрос резко вырастает.

Результат занял 90 минут работы автомата, и только 27 минут потратили на ручную работу. Отфильтровано 43 000 запросов по частоте, 47 000 запросов по похожести. На выходе получили чистую семантику на 7500 фраз. Ручная чистка без автоанализа похожести заняла бы не меньше 5 часов (плюс такое же время автосъема частот в KeyCollector).

Что еще можно сделать?

Можно выгрузить список конкурентов и собрать по нему другие параметры, которые в исследовании показали себя как полезные.

Для этого можно использовать A-parser, CheckTrust, RDS API и аналоги.

Так выглядит итоговая таблица (пока без подгрузки кластеризации):

Когда у вас 200 запросов на продвижении, вы вручную можете проверить все запросы. Но когда к вам приходит на продвижение большой интернет-магазин, у которого 20 000 запросов, без подобного анализа вы будете тратить время на работы по запросам, которые никогда не продвинутся.

Далее все объединяется с кластеризацией, и вы сразу видите вероятность выхода по запросу каждого кластера. Делаете акцент на наиболее вероятных кластерах и получаете отдачу от продвижения гораздо быстрее и заметнее.

Успеха вам в продвижении своих и клиентских проектов.